技術論壇

發文時間 2020/02/25 作者 zhoujieren8

瀏覽次數 4192 留言數量 5 按讚 0

辨識技術類(影像、圖片、臉部識別等) 手掌辨識生物辨識AmazonGo

前陣子聽到身旁的幾個研究夥伴在討論Amazon的"非接觸式的生物辨識系統"具說能夠捕捉手上最最微小的紋路甚至能夠捕捉皮膚裡面的血管來辨識,但是這是真的嗎?請問有大大能跟我解釋Amazon的手掌辨識新專利到底厲害在哪嗎?

發文時間 2020/02/26 作者 omnixri

按讚 0

「非接觸生物(視覺型)辨識系統」已存在數十年,其中「人臉辨識(包含2D,3D)」是最為人熟知的,也是近年來最熱門領域之一。除此之外,像是指紋、掌紋、指靜脈、掌靜脈、臉(頰)靜脈、虹膜辨識等技術也都可歸類在此一領域,而這些技術發展也都超過二十年以上,算是成熟技術,許多公司門禁系統早就使用指紋來進行辨識。

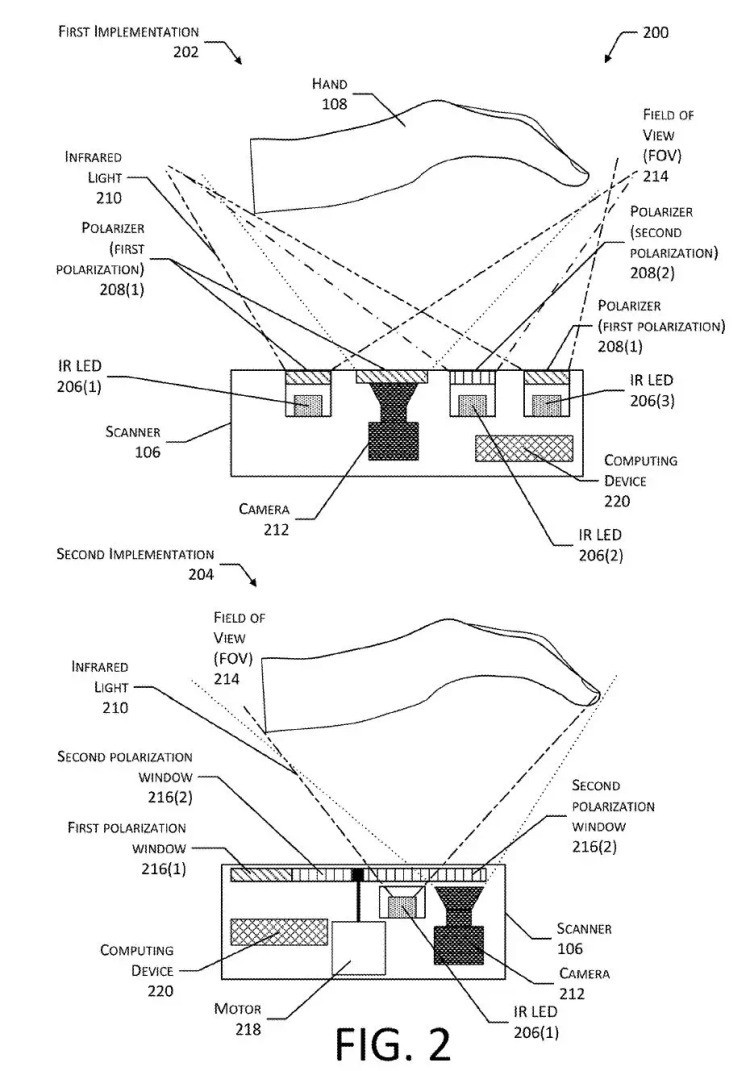

最近AMAZON推出的掌紋辨識系統主要結合兩個部份就是可見光偵測掌紋(表皮層)部份及紅外光偏光偵測靜脈(真皮層)部份。這兩項技術由來已久,只是AMAZON將其整合在一起並使用目前AI相關技術輔助,使其誤判率更低,期望未來能取代刷臉付款問題,並解決人臉辨識帶來的個人隱私問題。

相關新聞及圖片可參考:結帳只要0.3秒!亞馬遜手掌支付來了,不刷臉,刷手就能付錢

發文時間 2020/02/26 作者 omnixri

按讚 0

皮膚主要分成表皮層、真皮層及皮下組織,而微血管及小靜脈血管位於真皮層及皮下組織間。一般可見光只能看到表皮層,而在光源上加上垂直偏振濾光片,在攝像頭上加上水平偏振濾光片就能去除表皮層雜亂反光而看到真皮層內容。若再加上紅外光,則更容易看到靜脈,這個的作法普遍用在指靜脈、掌靜脈甚至臉頰靜脈(活體)身份辨識中。

不過為什麼這樣的技術不易普及,主要有一個麻煩處,就是在不同天氣情況下,靜脈及微血管組織可能反應會不同。冬天時手腳冰冷血液流動情況不佳,就像枯水期的河流一樣,導致原先記錄的特徵(分叉點)可能差異太多不易辨識。

另外目前人臉辨識有大量的公開或付費的資料庫可供人工智慧系統進行訓練及學習,但掌紋部份則較難大量收集及訓練,所以對於後續要進入普及階段可能還有好一段路要走。

發文時間 2020/02/26 作者 laisan86

按讚 0

這種技術其實在以往也有, 早期在生醫電子議題很夯的時候, 就有不少人發想過! 事實上, 人身上的指紋、掌紋就已經很久以前被用來做身分識別用, 目前比較先進的除了虹膜外, 就是像四肢裡面的血管分布來辨識. 也因此不只Amazon啦~~像NEC大約八年多前也推出過『指靜脈辨識器』

道理主要是利用近紅外光(Near IR)來當作相機一樣拍攝人體的靜脈分布圖, 其實也是流行一陣子囉, 像是這篇期刊:

主要的原理還是基於靜脈血液是處於缺氧狀態, 所以當紅外線照射缺氧的血液中的血紅素後, 紅外線會被吸收, 這樣就能像是用很多點描繪圖像的道理一樣, 把手指的靜脈分布圖給畫出來了!

我是不知道Amazon那專利的原文在哪邊, 不過可以告訴版主跟各位, 大約10多年前日本Hitachi就有推廣過類似的方案, 然後運用在提款機上, 輔助提款的人除了卡片以外的身分識別

發文時間 2020/03/04 作者 bioasura

按讚 0

看到專利裡面有一張這樣的說明, 在概念上似乎也是針對手掌透過元件掃描手掌之後, 透過所採集到的訊號所呈現的結果去作為辨識的依據, 在傳統上, 其實只要能夠變成訊號有變化的結果, 例如X光(手掌的醫學影像), 或是各種不同的零件所發射波長所產生的穿透後被遮蔽的結果的訊號, 最後透過訊號的大小進行加成, 就可以產生一張這樣的圖像(至於用什麼零件, 用什麼波長, 就看需要穿透的程度

得到訊號以後, 就可以轉換成圖像辨識的方式來進行後面的處理與分析.

感覺在專利的執行上反而是如何的進行血管與掌紋形式相關演算法的成熟度, 或許是未來的重點.

PS:在網路上搜尋後來看到了這一篇文章, 感覺相關技術已經相對過去成熟很多, 版上有大大提到可以買相關的零件來掃描手掌, 自己試試看能否實作出來, 感覺這是個很有趣的題目, 作為身分識別的應用蠻有趣的

發文時間 2020/03/04 作者 bioasura

按讚 0

相關的產品看起來日趨成熟, 例如 "富士通劃時代新技術---手掌靜脈辨識系統 為何生物辨識即將成為趨勢?" (https://www.fujitsu.com/tw/solutions/business-technology/security/palmsecure/), 摘錄部份的文字

"眼睛虹膜、指紋等這些人體辨識卻容易被仿冒且取得,手掌靜脈辨識獨一無二。富士通手掌靜脈辨識是一種高安全的生物辨識技術。它的運用原理是使用近紅外線感應器取得手掌靜脈的分佈圖,儲存樣板,進而在電腦中建立每一個人獨特的手掌靜脈資料庫。透過電腦登錄每個人的手掌靜脈資料,可以從電腦裡面做刪除與管理。(非接觸性感應器掃描手掌靜脈影像) 取得靜脈近紅外線影像 在其他需要身份辨識的場所例如健身房、俱樂部、三溫暖等需要會員卡管制進出的地方"

醫院的開刀房,因為不需要碰觸感應器,開刀房的門禁可以透過電腦管理,所以可以減少醫生走錯開刀房的情況。國外的實例是病人的病歷資料中已經有手掌靜脈的資料記錄,如果發生意外等送入醫院急救的情況發生時,在無法辨識病人的身分時,可以透過手掌靜脈的資料來查出該病人的身分,

有人天生沒有指紋,指紋因為外傷改變了無法辨識,帶著手套無法辨識,手指髒掉了無法辨識、感應器經常被觸碰會降低壽命等等,必須接觸感應器有衛生上的問題等等。手掌靜脈辨識就沒有這些問題。根據統計,每一千萬人中只有八個人手掌靜脈分布圖會是相似的,他的精確性高達百分之九十九點九。

不需直接接觸感應器,既衛生又安全,容易被大眾接受,舉例來說,在傳染病流行的時間內,這種非接觸性的感應方式是最安全的,甚至在醫院的開刀房,醫生都可以戴著外科手套通過感應進行身分認證。"

上面這些內容看起來似乎確實好處多多, 特別在面對武漢病毒疫情的同時, 似乎有許多有趣的應用 :D

像是實作來講, 目前由於半導體技術的進步, 這類靜脈圖像掃描裝置, 還可以跟Arduino結合, 當成一個類似Shield那樣用:

https://www.researchgate.net/publication/319156018_Design_of_Finger-vein_Capture_Device_with_Quality_Assessment_using_Arduino_Microcontroller

版主或哪位大大想自幹為王, 歡迎哪! 不過我也找到坊間好比Raspberry Pi就已經有推出紅外線照相機了, 直接買來就可以開幹了!

https://www.raspberrypi.org/products/pi-noir-camera-v2/

Hackster.io還有詳細說明哩:

https://www.hackster.io/1ibrahimirfan/low-cost-palm-vein-authentication-system-74e917

作者 laisan86 發文時間 2020/02/26 按讚 0